Communauté

Atout Cerveau

Cerveau ou « Deep Learning » : qui gagnera ?

Des bases de l’intelligence naturelle à celles de l’intelligence artificielle.

Séminaire du Neurocercle animé par Mirta Gordon et Jeanny Hérault

Maison des Associations de Grenoble, 6, rue Berthe de Boissieux – Salle 319

Entrée libre dans la limite des places disponibles.

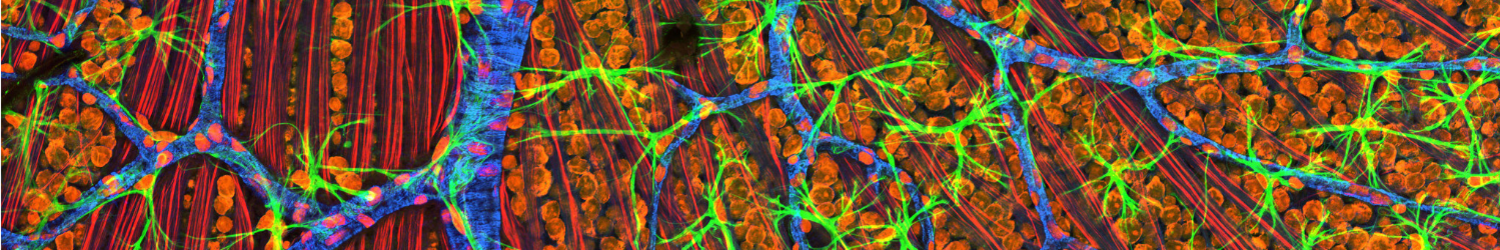

Personne ne met en doute le fait que notre intelligence soit due à nos neurones et à leur organisation en circuits complexes. Mais comment cela est-il possible ? C’est à partir du début du 20e siècle, qu’on commence à percer les secrets des réseaux de neurones et du cerveau. Depuis le neurone jusqu’aux structures nerveuses avec les prix Nobel : Golgi et Ramón y Cajal (1906) sur la structure du système nerveux, Dale et Loewi (1936) sur la transmission chimique des signaux nerveux, Hebb (1949) sur une règle d’apprentissage synaptique, Eccles, Hodgkin, Huxley (1963) sur les mécanismes ioniques dans la membrane nerveuse, Hubel et Wiesel (1981) sur l’analyse des informations dans le système visuel, Neher et Sakmann (1991) sur les canaux ioniques isolés dans les cellules, Kandel (2000) sur les bases moléculaires de la mémoire à court et à long terme, Axel et Buck (2004) sur l’organisation du système olfactif, O'Keefe et Moser (2014) sur les cellules de positionnement dans l'espace.

Dans une première partie, nous ferons le point sur les connaissances actuelles en matière de cellules nerveuses, sur leur complexité et sur les formidables capacités à traiter l’information qui en résultent (ou que l’on pressent). Corrélativement aux progrès de la biologie, des chercheurs issus des sciences dites « dures », mathématiciens, physiciens ou informaticiens ont essayé de comprendre et formaliser le traitement des informations par les neurones. Ainsi McCulloch et Pitts (1943) proposent le neurone formel, une abstraction du neurone physiologique, Rosenblatt (1969) développe le Perceptron, le premier système artificiel capable d'apprendre, Kohonen (1972) présente les mémoires associatives, avec des applications à la reconnaissance de formes, Hopfield (1982) étudie un réseau complétement rebouclé dont il analyse la dynamique, puis Rumelhart et LeCun (1985) proposent les réseaux de neurones multicouches, précurseurs des techniques modernes de « deep learning » (apprentissage profond).

Dans une seconde partie, nous préciserons les modèles de neurones formels, comment ils peuvent apprendre, en autonomie ou avec superviseur et nous montrerons comment, avec l’augmentation de puissance des ordinateurs, on tend dans un avenir proche vers des machine (presque) intelligentes. Diverses applications d’ores et déjà opérationnelles illustreront ces propos.

De 18:00 à 20:00