Intelligence artificielle et catastrophes naturelles

Publié par Encyclopédie Environnement, le 12 février 2021 5.3k

L'intelligence artificielle (IA), après plusieurs décennies de tâtonnements, fait aujourd'hui irruption avec force non seulement sur un plan scientifique mais aussi dans différents domaines d'activité humaine. Après avoir rappelé la définition de l'IA, nous verrons comment elle permettra d’aider à la prévention des catastrophes naturelles – et plus particulièrement ici, les risques naturels gravitaires (glissements de terrains, boues torrentielles, avalanches, éboulements rocheux).

Qu'est-ce-que l'intelligence artificielle ?

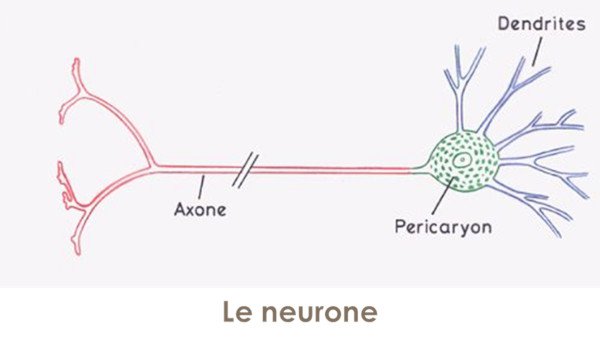

L'intelligence artificielle, c'est essentiellement la construction d'un réseau neuronal artificiel et la mise en œuvre d'une procédure d'apprentissage à partir de la donnée d'un certain nombre de solutions connues. L'idée initiale du neurone artificiel repose sur la reproduction, par des algorithmes, du neurone biologique du cerveau des êtres vivants, constitué schématiquement par quelques milliers de dendrites convergeant sur un noyau dont ressort un unique axone (fig.1).

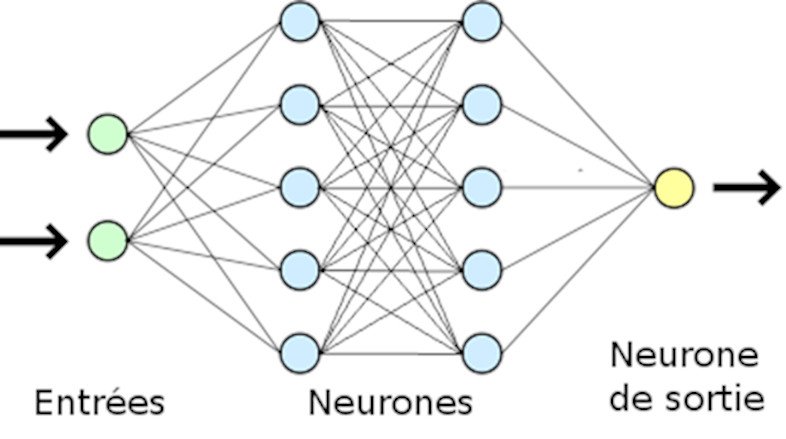

Quelques milliards de neurones, connectés entre eux par des synapses, sont ainsi présents dans notre cerveau, les stimuli étant transmis par des micro-impulsions électriques couplées à des processus chimiques. Un réseau neuronal artificiel est alors constitué par des nœuds, disposés en couches et reliés entre eux par des liens (fig.2).

A l'origine du développement de l'intelligence artificielle, le réseau neuronal était constitué par quelques dizaines de nœuds situés dans quelques couches disposées dans un plan. La méthode pouvait alors être considérée comme une simple méthode d'interpolation entre des données connues par l'utilisateur. Aujourd'hui, les réseaux neuronaux « massiques » rassemblent des millions de nœuds distribués en volume et leurs capacités créatives d'extrapolation sont bien établies. C’est ce qui est appelé le deep learning ou apprentissage profond. Par exemple, dans le jeu de GO, des stratégies inconnues de l'homme ont émergé dans la mise en œuvre du jeu par des algorithmes d’IA.

L'apprentissage d'un réseau neuronal, quant à lui, consiste à lui fournir en entrées (voir fig .2) des données dont les solutions sont connues. La calibration du réseau revient alors à donner aux différents liens des poids, déterminés - à travers l'apprentissage - par des méthodes mathématiques dites de « rétro-gradient ». Cette calibration aboutit à une définition implicite de l'hyper-surface passant par l'ensemble des points, dont les coordonnées correspondent aux entrées-sorties. Cette hyper-surface fournira alors pour de nouvelles données une sortie déterminée unique, si la surface est suffisamment régulière. Si, dans ses applications, la méthode rencontre des succès impressionnants et largement inattendus, sa maîtrise mathématique est cependant très loin d'être acquise aujourd'hui.

Pourquoi l'IA représente-t-elle une révolution aussi profonde ?

Jusqu'aux années 60, la méthodologie, appliquée pour résoudre un problème bien posé, consistait à le formaliser par un système d'équations. Puis ce système était résolu par des méthodes algébriques pour aboutir à une solution, explicitée sous la forme d'expressions elles-mêmes algébriques des variables ou fonctions inconnues recherchées. Il est très vite apparu que très peu de problèmes pouvaient être ainsi résolus. De fait, en pratique, seuls certains domaines de la physique étaient concernés.

La révolution numérique, qui a pris toute son ampleur à partir de la fin des années 60, a permis d'étendre de manière remarquable la gamme de problèmes traités. Aujourd'hui, pratiquement tous les problèmes qui peuvent être formalisés par un système d'équations peuvent être résolus numériquement (sous réserve naturellement de l'existence de solutions) par des algorithmes ad hoc.

Mais avec l'IA, un problème peut être simplement caractérisé par un ensemble fini de données, les big data, avec leurs réponses associées. Et la formalisation des entrées-sorties peut être réalisée par le code lui-même, qui peut ainsi « apprendre » sans intervention humaine : c’est le machine learning ou apprentissage automatique.

Par exemple, les règles d'un jeu ayant été introduites, le code d'IA mènera son propre apprentissage (c'est à dire, déterminera lui-même les poids affectés aux liens) en jouant contre lui-même. Ou bien, le code de la route ayant été formalisé, le logiciel d'IA apprendra à conduire une voiture en la faisant circuler de manière virtuelle dans une réalité elle-même virtuelle.

Si le réseau neuronal artificiel a cherché à reproduire notre réseau de neurones biologiques, l'apprentissage du réseau correspond à notre manière de résoudre les problèmes qui se posent à nous : non pas généralement en résolvant un système d'équations, mais par l'expérience accumulée appuyée sur les savoirs acquis lors de notre éducation (par exemple, le savoir-vivre) et de nos formations (en écoles ou autres). Ainsi, tout conducteur d'une voiture a dû d'abord assimiler le code de la route, puis a conduit une voiture-école pendant un certain nombre d'heures avant de s'estimer suffisamment formé pour être autonome. Quand des accidents se produisent pour le jeune conducteur, l'apprentissage est jugé insuffisant et de nouvelles heures de conduite en voiture-école lui sont imposées. De même, pour le logiciel d'IA, si le nombre de données avec solutions est trop restreint, l'hyper-surface évoquée au premier paragraphe sera trop imprécise pour qu'il puisse répondre avec pertinence à des questions correspondant à de nouvelles données.

Quelles applications pour les risques naturels ?

Des applications sont déjà opérationnelles telles que la voiture autonome, le diagnostic médical, les analyses ADN, les reconnaissances visuelle et vocale, la traduction automatique pour citer les plus connues. Pour ce qui concerne plus spécifiquement l’environnement, on peut penser à deux grands champs d'application : ceux (i) de la robotique intelligente visant à préserver l’environnement sur des plans techniques et (ii) de l'exploitation intelligente des très grands nombres de données, qui se rencontrent souvent dans l’étude des phénomènes naturels environnementaux. C’est ce deuxième aspect qui va être illustré maintenant.

Les risques naturels gravitaires comme les glissements de terrain, les boues torrentielles, les éboulements rocheux, les avalanches, apparaissent comme des problèmes difficiles pour leur analyse, leur prédiction et leur prévention essentiellement du fait de la complexité des matériaux impliqués : sols, roches, neiges sont le plus souvent constitués de plusieurs phases (grains ou blocs solides, eau, air) en interaction complexe entre eux. Les grains ou particules de sols, les blocs rocheux (voir un exemple en fig. 3 d’éboulement rocheux et en fig.4 de glissement de terrain) et les flocons de neige ont des formes contournées, variables dans le temps. Le sable peut s’écouler entre les doigts comme un fluide et se comporter comme un solide sur la plage où l’on peut déambuler sans difficulté - sauf en cas de sables mouvants! Ces difficultés irréductibles ont poussé au développement de modélisations numériques de plus en plus performantes et à la mise en œuvre de ce qui est appelé « le clone numérique » du glissement, de la falaise, etc, modèle numérique qui doit être alimenté par des mesures réalisées in-situ.

La révolution métrologique a fait émerger de nouvelles familles de capteurs peu coûteux, résistants dans le temps, peu gourmands en énergie, qui peuvent être disposés en grand nombre dans les terrains à surveiller (glissements de terrains, falaises rocheuses instables, …) ou dans les ouvrages dont le comportement doit être contrôlé (barrages, digues, centrales nucléaires, grands ouvrages d'art...). Ces capteurs peuvent mesurer des variations de longueurs (l’extensométrie), des variations d’angles (l’inclinométrie), des pressions d’eau (la piézométrie), des déplacements locaux (par le global positionning system ou GPS) ou globaux (par photogrammétrie) ; ils peuvent aussi utiliser des techniques de scanner laser en surface (par le light detection and ranging ou LIDAR) ou de radar (par l’interferometric synthetic aperture radar ou InSAR). Pour les grands linéaires tels que les digues, les fibres optiques sont mises en œuvre.

On obtient alors de très grandes bases de données, issues de séries temporelles et/ou spatiales. Il devient alors intéressant de valoriser ces bases par des techniques intelligentes qui permettent de détecter les points critiques de fissure/rupture/tassement/fuite d’eau, de fournir une analyse des mécanismes de ruine potentiels et même – à terme - de recommander les mesures de confortement ou autres à prendre. En fait, le seul point délicat aujourd’hui est la phase d’apprentissage automatique (machine learning) qui ne peut pas s’appuyer uniquement sur les cas de glissements ou d’éboulements qui se sont effectivement produits en ayant été instrumentés.

Ces algorithmes d'intelligence artificielle trouvent leurs limites quand l'hyper-surface évoquée plus haut n'est pas suffisamment régulière, ce qui conduit à des inexistences de solutions ou à des solutions multiples ou parce que le système étudié est pathologiquement sensible aux conditions initiales (comme en météorologie : voir notre article Introduction à la prévision météorologique).

Ce texte est tiré de plusieurs articles publiés dans encyclopedie-environnement.org, principalement les six suivants :

- Les risques naturels de François Nicot, Directeur de Recherche, unité ETNA, INRAE Grenoble

- Les glissements de terrains de Etienne Flavigny, Maître de Conférences Honoraire de l’Université Grenoble Alpes

- Glissements et éboulements rocheux, une fatalité ? de Denis Fabre, Professeur Emérite du Conservatoire National des Arts et Métiers, et Didier Hantz, Maître de Conférences de l’Université Grenoble Alpes

- Le sable : fluide ou solide ? de François Nicot, Directeur de Recherche, unité ETNA, INRAE Grenoble

- Les argiles : un nanomatériau naturel et surprenant de Etienne Flavigny, Maître de Conférences Honoraire de l’Université Grenoble Alpes

- Comment la matière se déforme : des fluides et des solides de Félix Darve, Professeur Emérite de Grenoble Institut Polytechnique

Ce travail a été réalisé grâce au soutien financier d'UGA Éditions dans le cadre du programme "Investissement d'avenir", et de la Région Auvergne Rhône-Alpes.

- Retrouvez-nous sur notre site internet encyclopedie-environnement.org

Retrouvez-nous également sur Facebook, Twitter et LinkedIn